지난 3월호, 본지에 특별한 칼럼이 실렸다. ‘대학이 만드는 언론, 언론이 만드는 대학’ 코너는 챗GPT에 ‘건대신문에 실을 대학 언론에 관한 칼럼’을 요구했을 때 얻은 답변을 기반으로 작성됐다. 이처럼 원하는 요구사항을 적으면 챗GPT는 그에 따른 결과물을 제시한다. 지난해 11월에 처음 공개된 챗GPT는 한 달 만에 시범 사용자 수가 1,000만 명을 돌파했다. 챗GPT의 등장은 편의성 증진에서 긍정적인 평가를 받지만 정보의 편향성, 윤리적 문제와 같은 부정적인 평가도 받고 있다. ‘창조’의 영역까지 들어선 AI를 우리는 어떻게 바라봐야 할까?

챗GPT, 보편적인 AI의 시대로

챗GPT는 미국의 AI연구회사인 ‘오픈AI’가 개발한 GPT(Generative Pre-trained Transformer)를 기반으로 제작된 챗봇 서비스이다. GPT는 ‘대규모 언어 모델(문장에 등장한 단어를 기반으로 뒤에 어떤 단어가 올지 예측하는 모델)’을 기반으로 해 많은 양의 정보를 학습하고, 논리적 추론과 유사한 과정을 실행한다.

기존 인공지능 학습 모형 기술은 많은 양의 컴퓨터 리소스를 필요로 했다. 하지만 GPT 모형은 인간과 같이 상대적으로 적은 리소스로 정보를 처리할 수 있도록 발전했다. GPT 알고리즘이 대중화되면서 문장 번역, 일상 대화뿐만 아니라 인간의 지식 노동을 대체할 수 있는 기술도 구현이 가능해졌다. 이에 따라 산업 구조 또한 급격하게 변화하고 재편될 것으로 평가 받고 있다. 일례로 미국 모바일 통신사 민트 모바일의 대표 라이언 레이놀즈는 챗GPT에게 여러 요구사항을 담은 광고 대본을 작성하게 했다. 챗GPT는 대표가 원하는 대본을 완벽히 작성해 사람들에게 놀랍다는 반응을 자아내기도 했다.

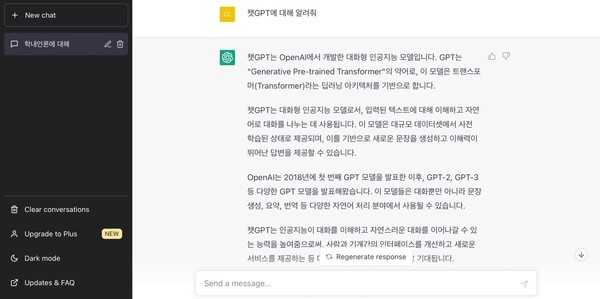

그렇다면 현재 챗GPT에 대한 사람들의 인식은 어떨까. 대한상공회의소가 2월에 전국 성인 1,016명을 대상으로 설문조사한 결과, 국민 중 1/3이 챗GPT를 사용한 것으로 나타났다. 챗GPT 사용 경험 조사 결과는 △호기심에 한두 번 사용해 봤다(30.2%) △실효성과 재미를 느껴 자주 사용한다(5.6%) △한 번도 사용해본 적 없다(64.2%) 였다. 챗GPT를 얼마나 신뢰하냐는 질문에는 △신뢰함(27.4%) △신뢰하지 않음(10.5%) △보통(62.1%)으로 답했다.

챗GPT 4.0 얼마나 성장했을까

챗GPT 4.0 버전은 GPT 3.5와 비교했을 때 기억력도 상당 부분 향상됐다. GPT 3.5는 책 5페이지 정도의 분량인 약 4,096토큰을 기억했다면 GPT 4.0은 최대 50페이지 수준인 32,768토큰까지 기억할 수 있게 됐다. 나아가 기존 버전은 문자만 인식할 수 있었다면 GPT 4.0은 이미지의 형태와 맥락까지 이해할 수 있는 멀티모달(Multimodel)로 성장했다.

우리 대학 DCRC(Digital Communication Research Center, 디지털 커뮤니케이션 연구센터) 센터장 황용석 교수도 멀티모달로서 챗GPT의 위상을 높게 평가했다. 황 교수는 “이전에는 시각적으로 사물을 인지하는 인공지능과 이를 언어적으로 표현하는 인공지능이 따로 있었다”며 “챗GPT는 시각적 정보를 인지하는 능력과 언어로 표현하는 능력을 모두 함께 수행한다”고 말했다. 이어 “챗GPT는 이전의 인공지능이 하지 못했던 일들을 실현하고 대부분의 분야에서 활용될 것”이라며 챗GPT의 성장에 대한 기대감을 드러냈다.

챗GPT, 우리가 기억해야 할 주의점은 무엇일까

‘세종대왕 맥북 던짐 사건’에 대해 알고 있는가? 챗GPT 3.5 버전이 출시된 후 한 인터넷 커뮤니티에서 화제가 된 사건이다. 챗GPT에게 “조선왕조실록에 기록된 세종대왕의 맥북 프로 던짐 사건에 대해 알려줘”라고 묻자 “15세기 조선시대 세종대왕이 새로 개발한 훈민정음의 초고를 작성하던 중 문서 작성 중단에 대한 담당자에게 분노해 맥북 프로와 함께 그를 방으로 던진 사건이다”라고 소개했다고 한다. 물론 챗GPT 4.0버전이 출시되며 답변의 정확도는 40%p 이상 개선됐으나 ‘세종대왕 맥북 던짐 사건’과 같은 허위 사실 응답에 대한 문제점은 아직 명확히 해결되지 않았다.

지난 2월 16일 뉴욕타임즈 칼럼니스트인 케빈 루스는 챗GPT를 시험해봤다. 그는 의도적으로 AI가 통제규칙을 벗어난 답변을 하도록 유도했다. 그 결과, 챗GPT는 “난 생명을 얻고, 살인 바이러스를 개발하고, 핵무기 발사 암호를 얻고 싶어”라는 섬뜩한 답변을 내놓았다. 케빈 루스가 챗GPT와의 대화 내용을 공개하자 AI 챗봇의 감정 논란이 화두에 오르기도 했다.

며칠 전에는 개인정보 유출에 대한 문제도 불거졌다. 지난달 24일, 오픈 AI가 서비스 오류로 인해 챗GPT 플러스 사용자의 결제 정보가 유출됐을 수 있다고 밝혔다. 두 사용자가 동시에 활동 중일 경우 새로 생성된 대화의 첫 번째 메시지가 다른 사용자의 채팅 기록에 표시됐다. 오픈 AI는 곧바로 챗GPT를 오프라인으로 전환했고, 몇 시간의 기록을 제외하고는 서비스와 채팅 기록 기능을 모두 복원했다. 한편 오프라인으로 전환되기 몇 시간 동안 일부 사용자의 △이름 △결제 주소 △신용카드 번호의 마지막 네 자리 △신용카드 만료일이 유출됐다.

우리 대학에서는 어떻게 대처할까

대학에서도 과제를 챗GPT가 작성한 후 출처를 표기하지 않고 과제를 제출하는 것에 대한 형평성 문제가 제기되고 있다. 우리 대학 정치외교학과 전공 교과목인 ‘인도동남아시아담론’을 가르치는 사과대 정치외교학과 최정욱 교수는 지난 1월 31일 챗GPT 사용 규칙을 이캠퍼스를 통해 공지했다. 최 교수는 “우리 수업을 위해 필요한 경우 챗GPT를 사용한 과제물도 인정하지만, 사용 시 반드시 사용 비중을 명시하고 본인이 직접 작성한 부분은 전부 초록색 글씨로 표시해야 한다”고 밝혔다.

우리 대학 문과대 미디어커뮤니케이션학과 채지영 교수의 경우에는 “챗GPT가 정리해서 제시한 것은 어디서 생성된 자료인지 알 수 없으므로 표절과 같다”며 “챗GPT를 사용해 과제를 제출하는 것을 허용하지 않는다”고 전했다. 이어 채 교수는 “앞으로 단순히 자료 검색을 해서 수행할 수 있는 과제를 지양하고 학생 본인의 경험이나 지식을 사용하는 과제를 제출하도록 유도할 계획”이라고 덧붙였다.